La inteligencia artificial generativa está revolucionando el mundo empresarial, transformando las operaciones internas y mejorando la comunicación con clientes y empleados. Gracias a sus aplicaciones innovadoras, desde el procesamiento inteligente de documentos hasta la personalización avanzada de contenido de marketing, las empresas están incorporando estas soluciones para optimizar sus procesos y servicios.

En las grandes corporaciones, donde existen múltiples unidades de negocio (LOBs), Amazon Web Services (AWS) ha emergido como una herramienta clave para centralizar la gobernanza a través de una estrategia de múltiples cuentas. Las empresas implementan «zonas de aterrizaje» que permiten la creación segura y gestión automatizada de cuentas en sus distintos entornos. Aunque cada LOB opera de manera autónoma, un equipo central, el Centro de Excelencia en la Nube (CCoE), asegura el cumplimiento de las políticas de gobernanza y gestiona el acceso.

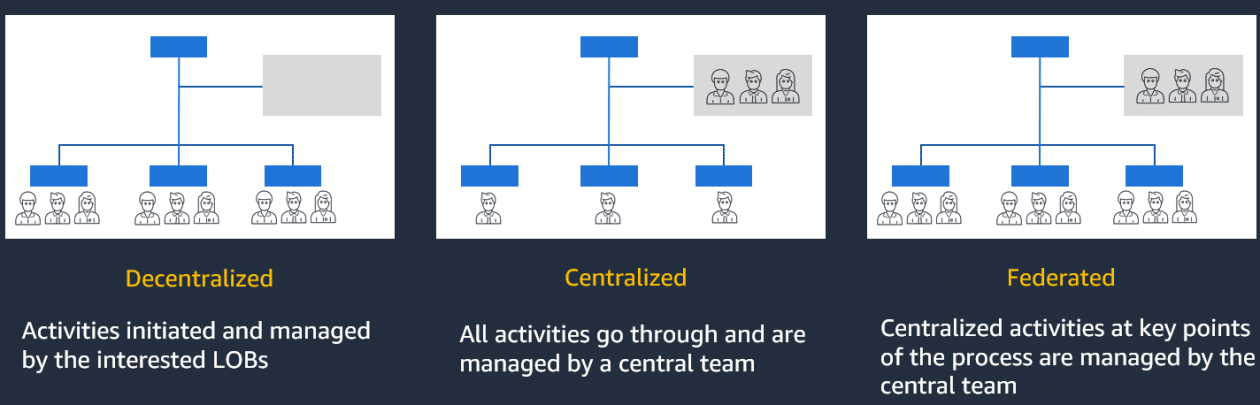

La necesidad de un modelo operativo para estructurar el uso de la IA generativa es cada vez más evidente. Este modelo abarca aspectos como el diseño organizacional, procesos clave, tecnologías, roles necesarios, estructuras de gobernanza y modelos financieros que guían la operación empresarial. Dependiendo de sus prioridades en agilidad, gobernanza y control, las empresas pueden adoptar modelos operativos descentralizados, centralizados o federados.

El modelo descentralizado otorga a las LOBs la libertad de desarrollar y desplegar IA generativa independientemente, promoviendo agilidad, pero con la necesidad de adherirse a los controles centrales. El modelo centralizado dirige todas las actividades de IA generativa a través de un equipo especializado, facilitando la estandarización aunque podría ralentizar el proceso de comercialización. El modelo federado busca equilibrar control y autonomía, permitiendo que las LOBs innoven mientras un equipo central supervisa las políticas de seguridad y normativas, aprovechando el conocimiento especializado de cada unidad.

Para llevar a cabo estos modelos, es crucial integrar componentes de arquitectura y servicios que potencien la IA generativa. Los modelos de lenguaje grande (LLMs) juegan un papel central, a pesar de presentar desafíos como la generación incorrecta de respuestas. Técnicas como la generación aumentada por recuperación (RAG) pueden mejorar la precisión al integrar capacidades de recuperación de información con modelos generativos.

Las empresas deben también asegurar la privacidad y calidad del contenido. Mecanismos de filtrado pueden alinear las interacciones IA-usuario con las políticas corporativas, mientras que la gestión de costos mediante herramientas de AWS permite monitorear el uso y costos asociados a estas soluciones.

En un entorno empresarial dinámico, la adaptación rápida a los avances en IA generativa es imperativa. Los modelos operativos federados emergen como una solución eficaz para promover la innovación y experimentación, mientras que un equipo centralizado garantiza el cumplimiento de las mejores prácticas y estándares de gobernanza. Con plataformas como Amazon Bedrock, las empresas tienen a su disposición una base sólida para desarrollar y escalar sus aplicaciones de inteligencia artificial generativa, allanando el camino hacia una transformación digital integral.