Amazon ha dado un nuevo paso en la evolución de los asistentes virtuales con la presentación de Nova Sonic, un sistema diseñado para generar conversaciones de voz a voz que imitan el habla humana de manera natural. Esta tecnología permite a los usuarios interactuar en tiempo real con la inteligencia artificial, comprendiendo el tono de la conversación y asegurando una comunicación fluida.

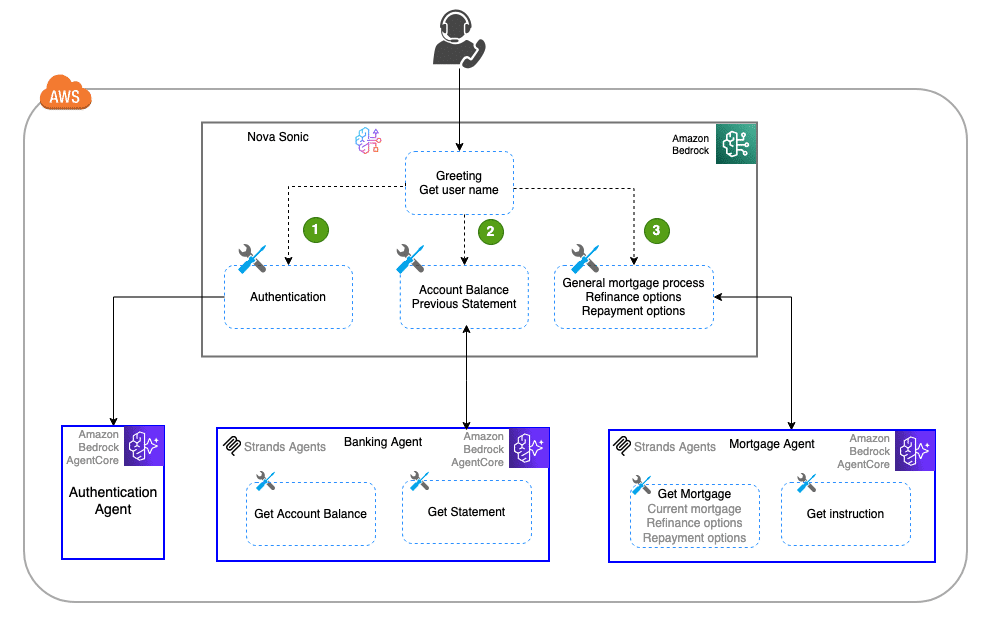

El punto fuerte de Nova Sonic es su arquitectura multicliente, que se distingue por ser modular, robusta y escalable. Estos atributos la hacen idónea para aplicaciones de voz de alto rendimiento. Los agentes de voz integran el marco de sub-agentes de Strands y utilizan Amazon Bedrock AgentCore, creando un sistema efectivo para gestionar múltiples clientes simultáneamente.

La arquitectura está inspirada en la estructura de equipos empresariales, donde los miembros se especializan en tareas específicas. Esta especialización permite manejar tareas complejas de manera más eficiente y con menos errores. Cada agente se convierte en experto en un área, como atención al cliente o verificación de datos, mientras el usuario experimenta un servicio continuo y sin interrupciones perceptibles.

Nova Sonic es particularmente útil en sectores como el financiero, donde un agente puede gestionar desde la verificación de identidad hasta la resolución de consultas bancarias. La modularidad del sistema facilita su mantenimiento y reutilización de flujos de trabajo desarrollados para aplicaciones que emplean modelos de lenguaje a gran escala.

Se destaca un caso práctico en el ámbito bancario, donde un asistente de voz utiliza sub-agentes especializados para tareas como autenticación y consultas de saldo. Esta división en sub-agentes simplifica la lógica del asistente principal y encapsula la lógica de negocio, lo que facilita el mantenimiento del sistema.

La integración de Nova Sonic con AgentCore se realiza mediante eventos de uso de herramientas. Durante el ciclo de vida de un evento de Nova Sonic, se configuran acciones para invocar sub-agentes según la consulta del usuario. Esto permite que el asistente maneje requerimientos específicos eficientemente, delegando las consultas más complejas a sub-agentes adecuados que proporcionan respuestas detalladas y precisas.

Para mantener un rendimiento óptimo, es esencial equilibrar flexibilidad y tiempo de respuesta. Modelos más pequeños pueden usarse para sub-agentes, reduciendo la latencia y mejorando la interacción, mientras que los más grandes se reservan para tareas que necesiten un mayor entendimiento del lenguaje. Esta estrategia no solo optimiza la experiencia del usuario, sino que también permite una implementación más eficiente de aplicaciones de inteligencia artificial.