En el cierre de las ponencias de machine learning en la conferencia Hot Chips, Google sorprendió con el lanzamiento de Ironwood, la nueva generación de sus Tensor Processing Units (TPU). Esta innovación está diseñada específicamente para la inferencia de modelos de lenguaje y razonamiento a gran escala, marcando una evolución respecto a generaciones anteriores que se centraban en el entrenamiento de modelos.

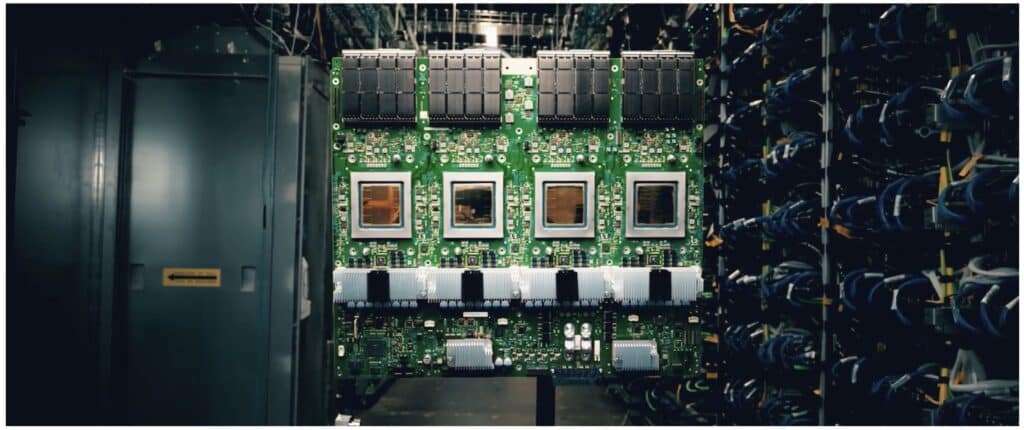

Ironwood, a diferencia de sus predecesores, se enfoca en ejecutar en producción arquitecturas avanzadas como los LLMs y los modelos de razonamiento, donde la latencia y la fiabilidad son esenciales. Esta nueva tecnología permite escalar hasta 9.216 chips en un solo nodo, alcanzando 42,5 exaflops de rendimiento (FP8), junto a 1,77 PB de memoria HBM3e directamente direccionable. Este avance duplica la escala respecto a la anterior generación, TPUv4, que soportaba 4.096 chips.

La eficiencia energética de Ironwood es notable, ofreciendo el doble de rendimiento por vatio que Trillium y hasta seis veces más eficiencia comparado con TPUv4. Esto se debe a su arquitectura multi-chiplet, avanzados stacks de memoria y un sistema de refrigeración líquida de tercera generación. Además, Google ha priorizado la fiabilidad, implementando características como checkpointing automático y detección de corrupción de datos.

Una de las particularidades de Ironwood es que su diseño interno fue optimizado utilizando inteligencia artificial, en colaboración con el equipo AlphaChip de Google, reflejando una tendencia emergente en la que la IA no solo ejecuta tareas, sino que participa en el diseño del hardware.

Ironwood incorpora la cuarta generación de SparseCore, lo que mejora el rendimiento en operaciones críticas para modelos masivos. Además, su infraestructura está diseñada para conexiones eficientes a través de optical circuit switches, lo que permite reconfigurar el sistema en caso de fallos, aportando mayor estabilidad y fiabilidad, factores cruciales en aplicaciones de IA generativa.

Este nuevo chip no se venderá como hardware independiente, sino que estará disponible exclusivamente en Google Cloud, integrado en la oferta de Cloud TPU. Esto fortalece la estrategia de Google de desarrollar su propia infraestructura para mejorar sus servicios en la nube.

En conclusión, con Ironwood, Google aspira a reforzar su posición de liderazgo en el ámbito de la inteligencia artificial, específicamente en lo que respecta a hardware especializado para inferencia masiva. En una era dominada por modelos de IA cada vez más complejos, Ironwood promete un rendimiento superior, optimización energética y una fiabilidad que podría definir el futuro de la computación en la nube.