Las organizaciones están mostrando un creciente interés en los modelos de base para llevar a cabo tareas de inteligencia artificial y aprendizaje automático, demandando una gestión eficiente en operaciones de inferencia a gran escala. En este contexto, Amazon Bedrock se posiciona como una herramienta esencial, ofreciendo dos patrones de inferencia: en tiempo real y por lotes, esta última siendo ideal para el procesamiento de grandes cantidades de datos sin la necesidad de resultados inmediatos.

La inferencia por lotes se destaca por su costo eficiente, ofreciendo un 50% de descuento en comparación con el procesamiento bajo demanda. Es así como se convierte en la opción preferida para cargas de trabajo considerables, aunque no estén sujetas a restricciones de tiempo. Sin embargo, la implementación a gran escala de esta modalidad implica desafíos significativos, incluyendo la gestión de formatos de entrada, la administración de cuotas de trabajo, la orquestación concurrente y el postprocesamiento efectivo. Este panorama subraya la necesidad de un marco robusto que facilite el manejo de estas operaciones.

Recientemente, se introdujo una solución escalable para optimizar el flujo de trabajo de la inferencia por lotes, capaz de gestionar eficientemente las necesidades inherentes a los modelos de base. Esta metodología permite, por ejemplo, la generación de embeddings para millones de documentos o la ejecución de evaluaciones complejas con grandes conjuntos de datos.

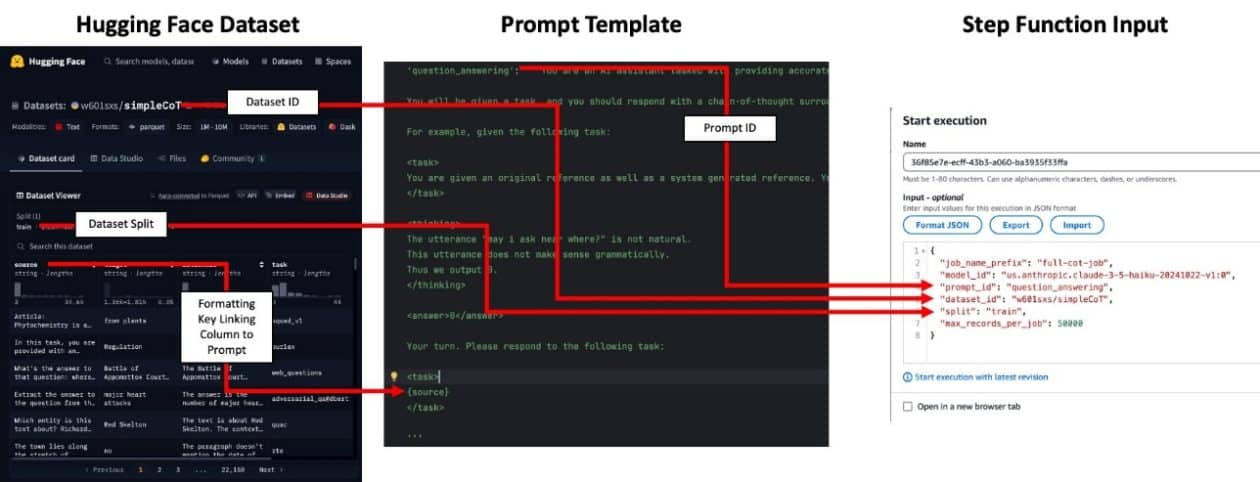

El proceso se estructura en tres fases clave: preprocesamiento de datos de entrada, ejecución paralela de trabajos de inferencia, y postprocesamiento de los resultados generados. Mediante un input de configuración sencillo, el sistema AWS Step Functions organiza la preparación de datos, la ejecución simultánea de los trabajos y el posterior análisis de los outputs.

Un ejemplo práctico de esta arquitectura contempla el análisis de 2.2 millones de filas de datos del conjunto SimpleCoT, diseñado para entrenar modelos en razonamientos complejos. La solución estructurada se basa en componentes escalables sin servidor, integrando inputs en archivos JSONL almacenados en Amazon S3 y gestionando cuotas específicas según el modelo a emplear.

Asimismo, Step Functions coordina los trabajos prolongados, mientras que Amazon DynamoDB se encarga del seguimiento del estado de cada proceso. La integración de estos elementos garantiza que los datos de entrada se fusionen adecuadamente con los resultados finales, facilitando la generación de embeddings o respuestas textuales sin la necesidad de identificadores de prompt específicos para la mayoría de los modelos.

Con su implementación, las empresas tienen ahora la oportunidad de explorar un enfoque arquitectónico sin servidor para el procesamiento por lotes a gran escala, fomentando la generación de datos sintéticos y la obtención eficiente de etiquetas de datos. Esta innovadora solución ya está disponible en un repositorio de GitHub, donde los desarrolladores podrán adaptarla a sus necesidades específicas, marcando un nuevo capítulo en la administración de inferencia por lotes a gran escala.